Genomskinlig maskininlärning: att få AI att förklara sina beslut

- Jag erbjuder konsulttjänster inom maskininlärning, AI och statistik – bland annat hjälper jag företag med öppna sina ”black box”-modeller. Kontakta mig för att få veta mer.

I mars kommer jag att hålla tre föredrag vid (populär)vetenskapsfestivalen Scifest i Uppsala. Dels två föredrag riktade mot högstadieelever och dels ett föredrag för allmänheten lördagen 9 mars. Mer information om plats och tider finns på Scifests hemsida.

Beskrivningen av föredraget för allmänheten lyder som följer: Vad är AI och hur fungerar det egentligen? Vad kan man göra med AI idag och vad kommer man kunna göra i framtiden? I det här föredraget om vår framtid med AI stöter vi på självkörande bilar, lättlurade datorer, AI som diskriminerar, sökandet efter lycka och den oväntade nyttan med att lägga upp bilder på sin mat på sociala medier.

Varmt välkomna!

I mars kommer jag att ge ett föredrag i Borlänge, som huvudföreläsare på Teknikmässan. Jag kommer att prata om AI inför elever från årskurs 2 på natur- och teknikprogrammen från gymnasieskolor i hela Dalarna. Dels kommer jag att prata om vad AI faktiskt är och hur det kommer att påverka oss och dels kommer jag att förklara hur den matematik de lär sig på gymnasiet – som räta linjens ekvation och derivator – i själva verket är de byggblock som används för att konstruera AI. En spännande utmaning!

I höstas var jag för övrigt också i Borlänge och föreläste, vilket går att läsa mer om här.

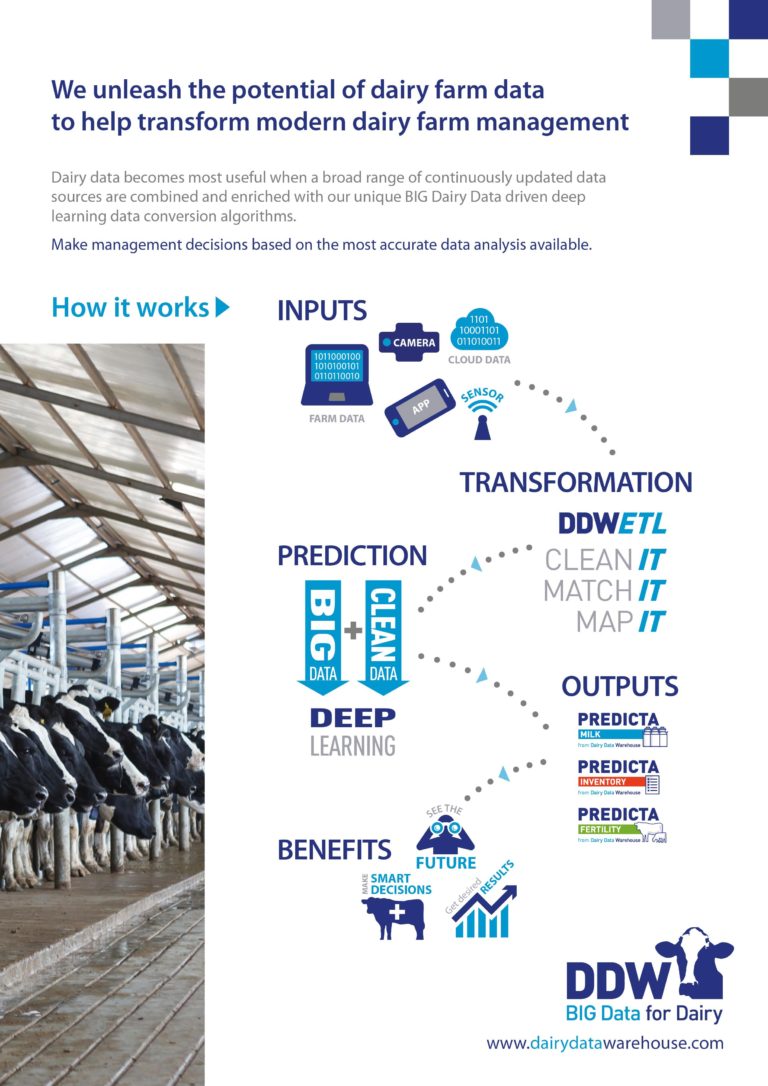

I våras hjälpte jag Dairy Data Warehouse att utveckla olika prognossystem för mjölkindustrin. I förra veckan lanserades några av de här systemen på den ledande mässan inom djurhållning: EuroTier i Hannover. De system jag varit med och utvecklat använder AI i form av djupinlärning (deep learning), där data från en rad olika källor (mjölkningsrobotar, fodersystem, avelsdatabaser, m.m.) vägs ihop för att göra prognoser för exempelvis hur mycket mjölk en ko kommer att ge det närmaste året.

Systemen kommer att kunna användas på flera olika sätt. Bonden kommer att få bättre underlag för att bedöma vilka djur hon ska behålla och för hur ekonomin kommer se ut framöver. Mejerierna kommer att få bättre uppskattningar av hur mycket mjölk de ska hämta olika dagar och kan därmed bättre planera de rutter som tankbilarna åker, med både ekonomiska och miljömässiga vinster.

Dagens mjölkindustri är teknikintensiv och full av system som samlar in data av olika slag. Dairy Data Warehouse har byggt upp en unik databas där data från alla dessa system samlas på ett och samma ställe. Med hjälp av den databasen har vi också utvecklat system som ska ge bättre djurhälsa och som knyter an till internet of things i ladugården och på mejeriet. Mer om det kommer en annan gång.

I slutet av september höll jag två föredrag i Borlänge om artificiell intelligens: hur det fungerar, vad man kan göra med AI idag och hur det kommer att påverka oss i framtiden. I samband med det blev jag intervjuad av Dalarnas Tidningar, Annonsbladet och Sveriges Radio (länken går till en nedklippt version av den direktsända intervjun).

Föredraget vid Dalarna Science Park livesändes på nätet och finns att se här (föredraget börjar 9:30 in i videon, och är uppdelat i två videoklipp).

(Ljudet är bitvis lite märkligt, gissningsvis eftersom jag hade två olika mikrofoner på mig. Men fullt lyssningsbart!)

(Ljudet är bitvis lite märkligt, gissningsvis eftersom jag hade två olika mikrofoner på mig. Men fullt lyssningsbart!)