Genomskinlig maskininlärning: att få AI att förklara sina beslut

- Jag erbjuder konsulttjänster inom maskininlärning, AI och statistik – bland annat hjälper jag företag med öppna sina ”black box”-modeller. Kontakta mig för att få veta mer.

I mars kommer jag att hålla tre föredrag vid (populär)vetenskapsfestivalen Scifest i Uppsala. Dels två föredrag riktade mot högstadieelever och dels ett föredrag för allmänheten lördagen 9 mars. Mer information om plats och tider finns på Scifests hemsida.

Beskrivningen av föredraget för allmänheten lyder som följer: Vad är AI och hur fungerar det egentligen? Vad kan man göra med AI idag och vad kommer man kunna göra i framtiden? I det här föredraget om vår framtid med AI stöter vi på självkörande bilar, lättlurade datorer, AI som diskriminerar, sökandet efter lycka och den oväntade nyttan med att lägga upp bilder på sin mat på sociala medier.

Varmt välkomna!

I mars kommer jag att ge ett föredrag i Borlänge, som huvudföreläsare på Teknikmässan. Jag kommer att prata om AI inför elever från årskurs 2 på natur- och teknikprogrammen från gymnasieskolor i hela Dalarna. Dels kommer jag att prata om vad AI faktiskt är och hur det kommer att påverka oss och dels kommer jag att förklara hur den matematik de lär sig på gymnasiet – som räta linjens ekvation och derivator – i själva verket är de byggblock som används för att konstruera AI. En spännande utmaning!

I höstas var jag för övrigt också i Borlänge och föreläste, vilket går att läsa mer om här.

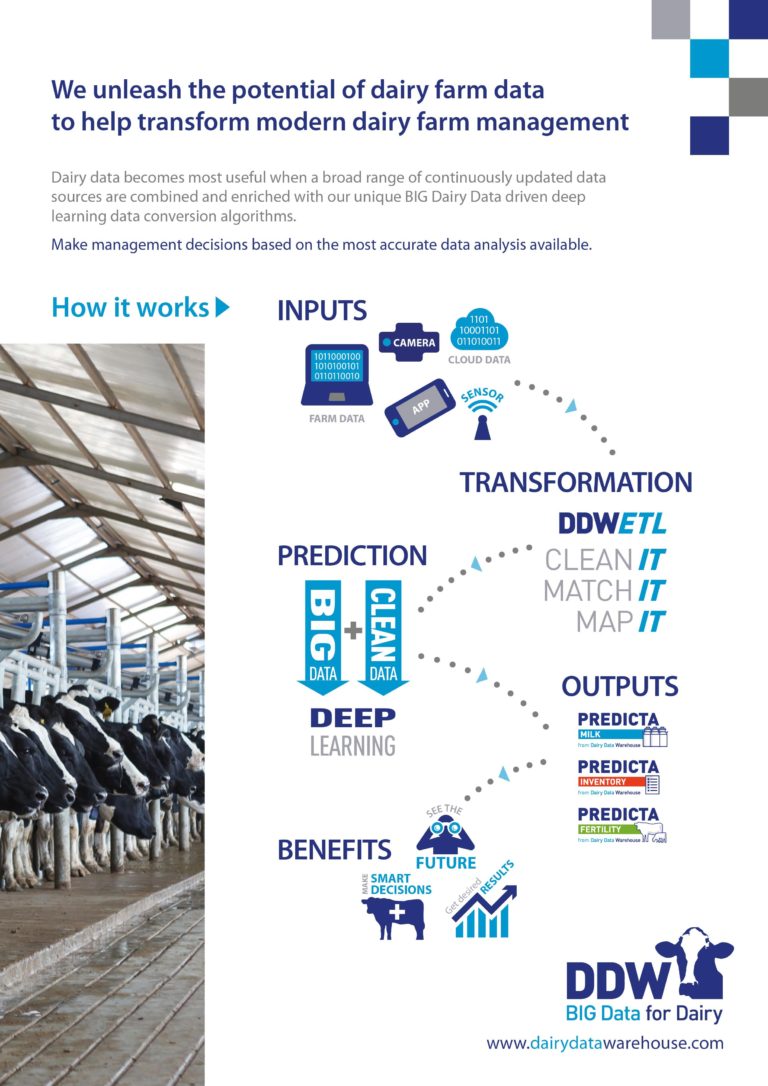

I våras hjälpte jag Dairy Data Warehouse att utveckla olika prognossystem för mjölkindustrin. I förra veckan lanserades några av de här systemen på den ledande mässan inom djurhållning: EuroTier i Hannover. De system jag varit med och utvecklat använder AI i form av djupinlärning (deep learning), där data från en rad olika källor (mjölkningsrobotar, fodersystem, avelsdatabaser, m.m.) vägs ihop för att göra prognoser för exempelvis hur mycket mjölk en ko kommer att ge det närmaste året.

Systemen kommer att kunna användas på flera olika sätt. Bonden kommer att få bättre underlag för att bedöma vilka djur hon ska behålla och för hur ekonomin kommer se ut framöver. Mejerierna kommer att få bättre uppskattningar av hur mycket mjölk de ska hämta olika dagar och kan därmed bättre planera de rutter som tankbilarna åker, med både ekonomiska och miljömässiga vinster.

Dagens mjölkindustri är teknikintensiv och full av system som samlar in data av olika slag. Dairy Data Warehouse har byggt upp en unik databas där data från alla dessa system samlas på ett och samma ställe. Med hjälp av den databasen har vi också utvecklat system som ska ge bättre djurhälsa och som knyter an till internet of things i ladugården och på mejeriet. Mer om det kommer en annan gång.

I det senaste numret av tidskriften Vatten finns en artikel om rening av enskilda avlopp, där jag hjälpt till med den statistiska analysen. Hushåll som har små egna avlopp måste också ha ett tillhörande reningsverk. I den här studien har man mätt halter av olika partiklar i vattnet som kommer ut från sådana reningsverk, hos mer än 200 hushåll.

För att mäta partikelhalterna har man tagit vattenprover, som sedan skickats till ett laboratorium. Problemet med sådana laboratoriemätningar är att de instrument som används bara kan mäta halter som är tillräckligt stora. Om halten ligger under laboratoriets detekteringsgräns så kan inget mätvärde ges. Istället kan man bara konstatera att halten är lägre än sagda gräns.

Första gången jag stötte på detekteringsgränser var i ett helt annat sammanhang – i ett projekt med Akademiska sjukhuset i Uppsala. Problemet med detekteringsgränser har nämligen också blivit vanligt inom modern medicinsk forskning, där man ofta är intresserade av halter av olika så kallade biomarkörer (exempelvis protein) i blod eller andra kroppsvätskor. Biomarkörer kan användas för att diagnosticera sjukdomar, välja behandling eller bättre förstå sjukdomsförlopp, men i många fall är halterna för låga för att laboratoriet ska kunna ge något riktigt mätvärde.

Så vad kan vi göra? Vi behöver inte slänga bort mätningarna bara för att vi inte kan få något säkert mätvärde. Vi vet ju faktiskt något om halten av ämnet – nämligen att den ligger under en viss gräns. Det är information som går att använda i vår statistiska analys, men däremot kan vi behöva andra verktyg än de allra vanligaste. Klassiska statistiska verktyg som t-test eller linjär regression stöter ofta på problem när de används på data med detekteringsgränser. Istället kan ickeparametriska metoder eller metoder från överlevnadsanalys användas, men vilken metod som är bäst beror på en rad olika faktorer. Om det har jag tidigare skrivit i den vetenskapliga tidskriften Statistics in Medicine.

En av de roligaste sakerna med att arbeta som statistiker är att man får lära sig om så många olika områden: från avloppsrening till sjukdomsdiagnostik. Och de statistiska problemen är ofta desamma oavsett vilket område data kommer från. Avlopp och blod kan verka som vitt skilda saker, men med statistikerglasögonen på är det knappt någon skillnad.